Pode ser difícil perceber como o racismo algorítmico atua nas redes digitais mas, de maneira implícita e sutil, eles reforçam uma visão de mundo e influenciam a sociedade.

Imagine que você quer fazer um penteado diferente no cabelo e pesquisa no Google Imagens algumas inspirações com o termo “tranças bonitas” em uma aba do seu navegador e na outra, “tranças feias” para ter exemplos do que não fazer. O resultado da busca te surpreende: na primeira pesquisa, são exibidas apenas imagens de mulheres brancas e de cabelo liso; na segunda, as fotos mostram mulheres negras de cabelo cacheado e crespo.

Essa polêmica é real e emergiu em julho de 2019, quando os resultados começaram a ser discutidos no Twitter. Muitas pessoas se demonstraram desapontadas e indignadas com o modo como a plataforma designou as imagens para cada um dos resultados. A Google se manifestou horas depois se justificando que seus resultados refletem “estereótipos existentes na internet e no mundo real em função da maneira como alguns autores criam e rotulam seu conteúdo”, mas que iriam trabalhar para mudar isso. Esse é apenas um de muitos exemplos de como o racismo se faz presente no meio digital. Sistemas automatizadas, como buscadores, podem contribuir na manutenção de desigualdades estruturais e microagressões cotidianas.

Para que a automatização desses sistemas seja possível é preciso fazer uso de algoritmos durante a programação dos mesmos. Algoritmos são códigos que vão capacitar o sistema a perceber certos tipos de comportamento dos usuários para aprimorar seu funcionamento. O racismo algorítmico acontece quando sistemas que dependem de algoritmos podem perpetuar ou esconder preconceitos raciais que já estão presentes na sociedade.

De acordo com a mestre e doutoranda em Ciência da Computação pela Universidade Federal de Minas Gerais (UFMG) Camila Laranjeira, existem dois tipos de algoritmos: os que aprendem com dados, ou seja, que obedecem aos comandos implementados; e aqueles que são treinados a partir de exemplos que lhes são apresentados e expostos. “O problema está nesse último modelo, porque as pessoas acabam considerando que ele é mais neutro, por não ter sido explicitamente programado por um ser humano. Mas, na verdade, é apenas o viés que muda de foco, ao em vez de ser um código instalado, o algoritmo é alimentado por dados selecionados por quem o produziu”, explica Camila.

Além disso, a especialista reforça a importância de compreender que o algoritmo em si não pratica o racismo e, sim, as pessoas que o desenvolveram. “O racismo está justamente nas informações que são repassadas para esses sistemas, pois elas são os resultados de uma sociedade estruturalmente opressora e racista”, diz.

Os algoritmos das plataformas e softwares utilizam informações vindas dos chamados bancos de dados. Essas informações incluem classe social, gênero, gostos pessoais, cidade onde mora, profissão… Normalmente, são usadas para as mais diversas finalidades, e suas aplicações vão depender do propósito de cada tecnologia. Um exemplo simples disso são as indicações de filmes da Netflix ou os tipos de produtos à venda que aparecem no seu perfil pessoal de rede social digital depois que você faz uma busca por um produto em uma loja online.

Assim, a programação dos algorítmicos representa as características predominantes da nossa sociedade, porque são seus programadores que moldam suas funcionalidades. “É importante ficar atento se o banco de dados consultado realmente é representativo, pois a falta disso traz diversas consequências, entre elas, a criação de um ciclo vicioso carregado de ideologias contra pessoas negras. Além de uma visão limitada sobre a realidade”, ressalta Camila.

Como o racismo algorítmico influencia na nossa vida?

O Google é um dos sites mais usados no mundo e uma das principais ferramentas de busca e acesso à informação no planeta. É considerado o “oráculo” do homem contemporâneo. , isso quer dizer que grande parte das pessoas confiam nos resultados por ele apresentados e, quase sempre, elas tomam decisões orientadas pelos primeiros resultados.

Entretanto, nem sempre o algoritmo da plataforma de buscas usa informações de forma adequada. Segundo pesquisa realizada pelo Instituto Brasileiro de Pesquisa e Análise de Dados (IBPAD), ao buscarmos o termo “família” no Google Imagens, a maior parte dos resultados são de famílias brancas – para ver as fotos de pessoas negras, é preciso rolar o cursor até o fim da página. Portanto, os primeiros resultados da busca, ou seja, os mais clicados, são sempre os de pessoas brancas. Isso demonstra como existe uma lógica de não associação de pessoas negras ao conceito de família. O que, por sua vez, contribui para invisibilizar as famílias negras e dissociá-las de outros termos de pesquisa.

“Portanto, a ordem dos resultados, definida algoritmicamente, tem papel relevante na reprodução de representações e acesso a informações consoantes ou dissonantes de olhares hegemônicos ou contra-hegemônicos”, explicaTarcízio Silva, Co-fundador e Diretor de Pesquisa de Comunicação do Instituto Brasileiro de Pesquisa e Análise de Dados. Dessa maneira, essas informações podem servir tanto para determinada empresa desenvolver um produto, como para reforçar preconceitos e estereótipos relacionados a população negra na sociedade.

A jornalista e doutora em Comunicação pela Universidade Federal de Minas Gerais (UFMG), Amanda Chevtchouk Jurno, explica que como as empresas responsáveis pelas redes sociais e grandes sites, como Google e Amazon estão nos Estados Unidos, “mais precisamente, na Califórnia, a visão de mundo que guia esses sites é apenas a dessa região, fazendo com que conteúdos pertencentes a outros contextos sejam prejudicados”.

Como exemplo, ela cita a questão da exposição de mamilos femininos no Instagram e Facebook, que considera imprópria imagens desse teor. “Nos EUA é incomum que mulheres exibam os seios em público, e como essas redes são produzidas por americanos, esse tipo de conteúdo passa a ser considerado inadequado. Em outras culturas, como a indígena, as mulheres ficam todo tempo com seios à mostra; as europeias fazem topless nas praias”, explica.

Em outubro de 2016, a revista Piseagrama teve sua página no Facebook bloqueada após publicar uma foto de uma mulher indígena com os seios à mostra. Como a repercussão da situação se restringiu aos seguidores da página, a plataforma não reverteu o bloqueio. A Piseagrama teve que criar nova página e publicar a foto novamente, desta vez editada, cobrindo os seios da mulher indígena.

Nana Miranda, pesquisadora sobre racismo algorítmico no YouTube, também propõe o questionamento das condições em que os algoritmos são gerados . “O fato de o desenvolvimento dessas tecnologias estar concentrado em pessoas específicas, geralmente homens cisgênero, heterossexuais e de classes sociais mais altas, diz muito sobre um locus de enunciação. O problema é que esse padrão vira universal e dita como serão as experiências de pessoas que não vivenciam essas circunstâncias”, diz ela.

Para a pesquisadora, quem produz essas tecnologias não consegue apreender outras subjetividades e isso afeta diretamente o resultado de como elas são aplicadas. Outra questão apresentada por Nana Miranda é a relevância dos indivíduos envolvidos quando ocorrem casos de racismo algorítmico: “Quanto mais relevante forem as pessoas, mais rápido a situação é solucionada”.

Em novembro de 2009, a Google lidou de outra maneira quando foram encontradas imagens da então primeira dama dos Estados Unidos, Michelle Obama, editadas para que ela se parecesse com um macaco. Por ser uma figura pública, ocupando cargo de alta visibilidade em todo o mundo, a empresa logo se pronunciou, afirmando que a página na qual a imagem estava era uma fonte de vírus e retirando o link correspondente do site de busca.

No entanto, outro link com a mesma imagem voltou a aparecer nos primeiros resultados de busca por imagens de Michelle Obama. A Google disse não ter como controlar seu algoritmo de busca que ranqueia resultados organicamente e que só iria excluir a página se violasse as regras de uso do site, sob obrigação legal ou a pedido do responsável da página em questão. Até hoje é possível encontrar a imagem no site de busca. Mesmo que o caso não tenha sido solucionado, é notória a diferença de retratação entre a Piseagrama e Michelle Obama.

Nana Miranda explica que estas questões são, relativamente, novas e por isso, se existe dificuldade em punir crimes de racismo, cibernéticos ou não, responsabilizar práticas das plataformas seria ainda mais difícil. “As grandes corporações também não assumem esse tipo de problema ou, quando o fazem, são em casos muito pontuais. Esta não é uma questão encarada como um problema estrutural e isso dificulta a resolução do problema”, complementa.

Casos de racismo algorítmico

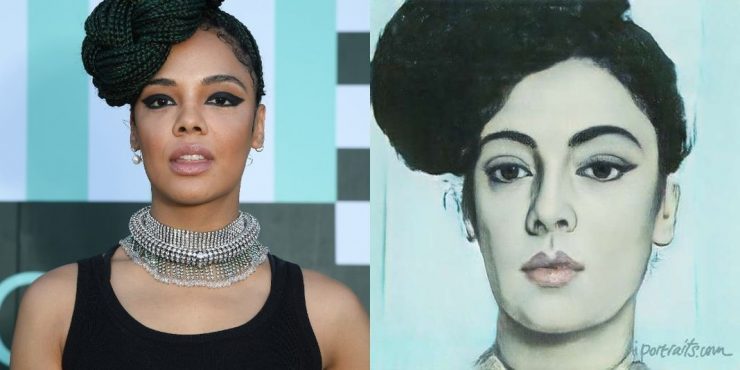

Em julho de 2019 o aplicativo e site AI Portraits Ars ganhou diversos usuários, o objetivo era criar uma versão renascentista de selfies a partir de fotografias que recriam pinturas do século 15. O usuário faz o upload de uma foto que é utilizada pelo sistema de inteligência artificial (IA) para recriação, resultando em uma imagem que tenha expressões e características da época. Desenvolvedores do site o criaram a partir de um banco de dados com mais de 45 mil retratos clássicos de pinturas a óleo, aquarela ou tinta, sendo treinado a partir desses exemplos.

Por se tratar de um período artístico com obras produzidas na europa ocidental, as pinturas representavam pessoas que eram maioria daquela região: indivíduos brancos. Portanto, o banco de dados do AI Portraits Ars tinha como base traços étnicos de pessoas, aplicando-os na criação das imagens inspiradas no renascentismo. Isso fez com que pessoas negras que utilizaram o aplicativo tivessem sua pele clareada e seus traços afinados na imagem final. Assim, as fotografias produzidas como resultado da edição apresentaram sinal de racismo. Hoje, o site não está mais disponível.

O caso do Google Photos

Outro exemplo de um caso que apresentou viés racista foi o Google Photos, que classificava fotografias de pessoas negras como gorilas. Esse dispositivo da Google cria álbuns para o usuário sem ser solicitado, diferenciado por “etiquetas” de pessoas e momentos, como por exemplo, eventos ou viagens. Nessa situação, um grupo de amigos nova-iorquinos passeavam em um parque e tiraram fotografias e, ao final do dia, a Google Photos sugeriu criar o álbum “gorilas” para a coleção de imagens, demonstrando o preconceito presente nessas bases de dados.

“Teve uma resposta popular muito forte, porque a Google não teve cuidado de considerar o viés no algoritmo, e sabemos como é extremamente essencial que tomemos cuidado com isso, pois alimenta um viés muito nocivo para a nossa sociedade”, comenta Camila Laranjeira. Além disso, o fato de a inteligência artificial aprender com dados alimentados majoritariamente por pessoas brancas, reforça um círculo vicioso de racismo e preconceito. Por exemplo, em pesquisas que são feitas para classificar a probabilidade de uma pessoa ser presa ou não, o resultado pode trazer viés racista por relacionar pessoas negras ao crime, ou promover uma visão de criminalização por etnia, consequência de uma sociedade racista e que vive o encarceramento desmedido dessa população.

Racismo na publicidade

A representatividade de pessoas negras em campanhas publicitárias, comerciais e nas redes sociais é algo que tem sido cada vez mais cobrado pela sociedade. Essa demanda tem gerado algumas mudanças nos materiais divulgados por marcas que se preocupam em estar engajadas socialmente.

Entretanto, bancos de imagens – tanto gratuitos, quanto pagos – não correspondem a esse processo de conscientização. Os famosos Shutterstock, Getty Images, iStock Photos e Depositphotos foram utilizados na iniciativa baiana Desabafo Social, realizada em 2017 por Monique Evelle. Em um vídeo, ela demonstra como na pesquisa dos termos “família”, “pessoa”, “bebê” e “pele”, a grande maioria das imagens apresentadas é de pessoas brancas, o que causa uma desassociação entre esses conceitos e pessoas negras.

A estudante de relações públicas e mulher negra, Alessandra Oliveira, percebe como o racismo algorítmico afeta os bancos de imagens em seu estágio. “Quando produzo peças gráficas, utilizo bancos de imagens e noto que em pesquisas gerais tenho que rolar muito a página para encontrar fotos com pessoas negras ou, então, incluir ‘negro’ na busca”, relata a estudante. Em um estágio anterior, teve que produzir uma peça para postagem motivacional e buscou o termo “casais felizes”, mas percebeu que pelo menos as 100 primeiras imagens exibidas eram de pessoas brancas. “Mesmo quando coloquei ‘casais negros felizes’ e ‘casal interraciais felizes’, apareciam imagens de casais brancos”, complementa.

No seu trabalho, ela dá preferência por imagens que tenham indivíduos que representem diversidade em suas produções, mas se diz decepcionada e frustrada por não encontrar pessoas que se pareçam com ela nos bancos de imagem. “Parece que estou numa corrida em que a linha de chegada toda vez é alterada, exclusivamente para mim e para outras pessoas pretas, e as brancas já estão com suas medalhas e muitas delas sem ter que correr”.

Para Alessandra é revoltante que o racismo na publicidade não seja considerado como discriminação pela sociedade, assim como várias outras micro agressões, que “a branquitude não vê como tal e, por isso, muitas vezes silencia”, acrescenta.

Por também se sentirem silenciados e não representados, um grupo de criadores negros da agência SHADE, de Brooklyn NYC, criou o Nappy, um banco de imagens com fotos de alta resolução de pessoas negras. Na descrição do site, idealizadores comentam: “[…] se você digitar a palavra ‘café’ no Unsplash (outro site de imagens grátis), raramente verá uma xícara de café sendo segurada por mãos pretas. É o mesmo resultado se você digitar termos como ‘computador’ ou ‘viajar’. Você pode encontrar uma ou duas imagens, mas elas são muito raras. Mas os negros também bebem café, usamos computadores e certamente amamos viajar”, relata.

Como combater o racismo algorítmico

Apesar de discussões éticas e jurídicas a respeito de algoritmos serem cada vez mais comuns, ainda não existe uma regulação própria, e assim, continuam reproduzindo preconceitos e opiniões com viés racista. Camila Laranjeira afirma que o caminho para diminuir o racismo algorítmico seria a incorporação de pessoas negras na execução das tecnologias e o uso dessa própria tecnologia para manipular, no melhor dos sentidos, alguns dados para diminuir estereótipos (ela cita o exemplo da população carcerária).

Para Nana Miranda, é preciso democratizar a tecnologia e o acesso à internet. “Atualmente, existe uma concentração midiática muito grande por parte de corporações como Google, Amazon, Facebook e Apple. Essa concentração é nociva por causa desse locus de enunciação, pois são tecnologias vindas sempre dos mesmos países, que acabam imprimindo seus padrões sociais e culturais”, explica. A pesquisadora ressalta que é necessário que haja uma regulação específica para que os ambientes se tornem mais democráticos. Para que isso aconteça, é importante que a sociedade civil, junto com órgãos governamentais, estejam mais atentos para que essas corporações ajam de forma mais responsável.

Nana conclui que, junto à democratização e à regulação das mídias, é preciso que as pessoas tenham acesso a uma educação digital. “Esse ‘letramento algorítmico’ permite que saibamos como as mídias são consumidas e utilizadas por nós. É imprescindível democratizar o conhecimento para a formação de pensamentos críticos acerca das tecnologias, que cada vez mais estão presentes no nosso cotidiano”, expõe.

Microagressões

O termo “microagressão” é utilizado, para traduzir o sentimento de pessoas que, por algum motivo, sentem-se afetadas por “indignidades verbais”, comportamentos do cotidiano intencionais ou não, que comunicam desprezo e insultos sutis, depreciativos ou negativos a pessoas negras e outras minorias.

Para ilustrar o que significa, suponhamos que alguém toque, sem permissão o cabelo de uma pessoa negra. Ainda que a intenção possa ter sido carinhosa, o gesto é uma forma de perpetuação da ideia de que indivíduos com determinadas etnias não possuem autonomia. Portanto, não são vistos como pessoas com vontades e sentimentos, que devem ter seus corpos preservados e seu espaço respeitado.

Da mesma forma, microagressores se materializam dentro do ambiente virtual, na medida em que pessoas que não estão dentro do padrão (negros, indígenas, pardos e mestiços) são sub-representadas nas mais diversas plataformas. Portanto, sua presença online e tudo o que diz respeito a essas pessoas na maior parte do tempo recebe pouca importância. Um exemplo disso, aconteceu em 2009, em uma ocasião em que o software de reconhecimento facial da Hewlett-Packward (HP) não conseguia identificar o rosto de um funcionário negro. Tal situação se configura como uma migroagressão, pois a pessoa, ao não ter seu rosto reconhecido, pode se sentir constrangida em meio aos demais. Essa falha do sistema diz muito sobre os vieses preconceituosos que podem estar embutidos nos aplicativos e algoritmos.

Reportagem produzida na disciplina de Edição Jornalística, sob a supervisão da professora Verônica Soares da Costa, pelos estudantes Debora Drumond, Francielle Laudino, Henrique Perez, José Aparecido, Júlia Bahia e Lívia Rigueira.

[…] O que é racismo algorítmico? […]

[…] Leia: Racismo algorítmico: o preconceito na programação […]

como posso colocar a referencia dessa reportagem nas regras da abnt? obrigada

Olá! Veja se este link te ajuda: https://blog.fastformat.co/como-fazer-citacao-de-artigos-online-e-sites-da-internet/