Nas últimas décadas, a tecnologia de inteligência artificial (IA) tem sido amplamente discutida, não só pelo campo acadêmico, mas também na cultura pop e, consequentemente, na sociedade. Sua aplicabilidade no dia a dia é diversa e, muito provavelmente, você a utiliza sem perceber. Ela está no seu computador, celular, envolvida no seu trabalho, estudos, etc.

O uso das IAs em livros como Eu, robô, do autor russo Isaac Asimov, pode trazer uma noção da tecnologia como algo estritamente perigoso. Flávio Figueiredo, professor e pesquisador da Universidade Federal de Minas Gerais (UFMG), conceitua inteligência artificial como “a máquina imitando aspectos da inteligência humana, ou seja, a máquina está realizando tarefas que humanos conseguem realizar”. O professor ainda complementa que as IA’s sempre existiram, “elas conseguem jogar damas antes mesmo da volta do estudo sobre elas [na década de 1970]”. A diferença que Figueiredo aponta é que, hoje em dia, ela é estudada de forma mais profunda, pois o que se faz é uma “outra forma de programar a inteligência artificial”.

Uma das principais técnicas de produção de IA existente é a machine learning. Hugo de Paula, professor de Ciência da Computação da PUC Minas, conceitua a técnica como um modo de ensinar o objetivo da inteligência artificial por meio de dados: “A partir dos dados que são inseridos na máquina, a IA aprende e cria as regras para cumprir seu trabalho”, explica. Uma subcategoria dentro da machine learning seria o deep learning, que recebe dados mais estruturados em diferentes camadas para dar um resultado mais preciso.

Ética ao se programar

Como a principal forma de “treinar” máquinas é introduzindo-as a dados, o que for entregue a ela será sua moral. “Logo, para que o computador julgue o que é certo ou errado, é necessário que seus programadores estejam conscientes de suas ações e consigam distinguir o que seria prejudicial ou não para a sociedade ao utilizar inteligências artificiais”, detalha Hugo de Paula.

Para que haja maior controle das atitudes e das consequências das inteligências artificiais, há alguns princípios. Um deles seria o princípio ART – sigla, no inglês, para accountability; responsibility; transparency -, sendo o primeiro “capaz de responsabilizar a pessoa pelos erros da IA”, de acordo com Hugo de Paula. Já a responsabilidade, refere-se à segurança e ao compromisso de transparência com o usuário que utiliza a IA e quais seriam os dados coletados. Os termos de uso e políticas de privacidade, que sempre são exigidos a se fazer uma conta de usuário em um site, servem para garantir a responsabilidade de que o internauta está ciente de que está passando seus dados e a empresa não irá fazer um uso deturpado deles.

A última parte do princípio, a transparência, discute como o sistema funciona. Casos como o Chat GPT, instrumento que ficou famoso desde novembro de 2022 por dar respostas a perguntas com rapidez e certa precisão, que não diz como funciona, nem qual é sua base de dados, feririam a ética sob esse aspecto. Hugo de Paula ainda cita que, em casos como a IA na medicina, o médico poderá se recusar a usar determinada tecnologia por não entender seus métodos.

Problemas com a IA

Sabe-se que vivemos em uma sociedade racista, sendo assim, ver Inteligências Artificiais reproduzindo o racismo dos seres humanos não é algo distópico e nem absurdo, conforme explica Daiane Araújo, assessora de tecnologia da Ação Educativa. Ela relata já ter sentido diretamente o racismo das IA’s ao passar por um constrangimento no aeroporto, quando estava no banheiro e, ao tentar lavar a mão, a torneira acionada por sensor não liberou a água por não conseguir distinguir a cor de sua pele preta.

Daiane ainda comenta que as tecnologias que são treinadas por base de dados, são “alimentadas” por bancos com imagens, em sua maioria, de pessoas brancas. “Profissionais da área estão atualizando as informações que são fornecidas por IA’s de machine learning e, assim, o caso de tecnologias reproduzindo racismo pode diminuir”.

Polêmica com câmera

No ano de 2021, diversos usuários de uma câmera profissional relataram que rostos não-brancos não eram identificados como pessoas no visor do equipamento, o que levantou alegações de uma governança racista. Isso se dá pelo aprendizado de máquina, na qual a IA é submetida para entender padrões.

Flávio Figueiredo, professor de Ciência da Computação da UFMG, explica o machine learning para o ColabCast, podcast do Colab, como um exercício de memória para a máquina. Segundo ele, o treinamento se dá por amostragem de fotos de um banco de dados. Como vivemos em uma sociedade racista, e os trabalhadores dessas empresas são majoritariamente brancos, a inteligência usada para a identificação dos rostos terá problemas em enxergar pessoas de tons de pele diferentes.

Confira a entrevista completa com Flavio Figueiredo, pesquisador de inteligência artificial da Universidade Federal de Minas Gerais:

Governança vs. Usuário

Em abril de 2023, iniciou-se o processo da PL das Fake News, que procurou regulamentar a circulação e fiscalização de plataformas sociais, de modo a evitar a propagação de notícias falsas – muitas delas geradas e ampliadas em razão da utilização das IA’s. Além do fator das fake news, a IA facilita o processo de entrega de conteúdos de forma diferente a depender do usuário, o que implica na existência de uma governança com valores pré-definidos – sejam estes éticos ou não.

A pesquisadora Dora Kaufman, da Universidade de São Paulo (USP), que estuda impactos éticos e sociais da IA, afirma que as inteligências artificiais têm uma carência de governo, principalmente em relação à IA preditiva, o que permite uma autonomia “desassistida” das IAs:

Todo o processo [de uso das ferramentas e geração de conteúdo via controle humano] tem decisões humanas. Então, significa que o desenvolvimento, elaboração, implementação e uso da inteligência artificial está permeado pela subjetividade. Há um grande viés, porque são humanos que tomam decisões, e não a máquina”.

Dora Kaufman, pesquisadora e professora da USP

Um exemplo que a pesquisadora dá é a descoberta de uma base de dados de uma empresa (sem nome divulgado) que desenvolveu uma inteligência artificial capaz de diferenciar com mais facilidade homens brancos de mulheres negras. Isso se dá pelo fato de que a base de imagens possuía mais imagens do presidente estadunidense Joe Biden, em posição de extremo privilégio racial e monetário, do que de mulheres negras, que estão no lado oposto da escala do privilégio. A solução, para ela, é uma base de dados com maior diversidade étnica, a fim de evitar a perpetuação de preconceito já contido na base de dados recolhida pelas IA’s.

Dora Kaufman ainda destaca que a predição das inteligências reflete os comportamentos tanto da governança (que engloba a gestão e o desenvolvedor da tecnologia), quanto do usuário: “A base de dados reproduz a sociedade, quem gera os dados somos nós, né? Então os preconceitos e todas as questões relacionadas aos seres humanos estão condensados naqueles dados”.

Como as IAs podem impactar o mercado de trabalho?

Um relatório feito pelo Fórum Econômico Mundial em 2018 apontou a inteligência artificial como um dos quatro principais fatores de mudança do trabalho. Recentemente, a preocupação de que as IAs irão tomar o lugar dos seres humanos no mercado de trabalho entrou em pauta com a popularização do Chat GPT. Ao ser perguntado quanto a isso, o próprio Chat responde que, apesar de ter o potencial de afetar muitas profissões, é importante lembrar que nem todas as tarefas podem ser substituídas por IAs.

Os tópicos citados pelo Chat são projeções, e a própria IA reforça que o impacto seria parcial, e não uma substituição completa. Até o momento, por exemplo, a condução autônoma de veículos apresentou falhas em testes e não se provou uma alternativa segura o suficiente para substituir totalmente os motoristas em muitos casos. Além disso, o valor de automóveis com essa tecnologia também seria um empecilho para garantir que essa substituição fosse sequer acessível para a maior parte da população.

Uma das principais utilidades das inteligências artificiais é a automação de tarefas repetitivas, padronizadas ou que dependem de processamento e análise de dados complexos. Com essas ferramentas, empresas conseguem reduzir custos e aumentar a produtividade, consequentemente, eliminam a necessidade de mão de obra e reduzem o número de empregos nessas áreas. Em contrapartida, o crescimento da demanda por inovação tecnológica implica no aumento da necessidade de profissionais nessa área e até mesmo na criação de novas ocupações.

Outra realidade que as IAs trazem para o mercado de trabalho é a necessidade de requalificação profissional e treinamento para utilização das ferramentas. A pesquisa feita pelo Fórum Econômico Mundial ainda aponta que cerca de 42% dos empregos sofreriam esta demanda por requalificação. Com isso, 54% dos trabalhadores devem desenvolver novas habilidades, sendo 35% com treinamento mínimo de seis meses, 9% de seis a 12 meses, e 10% de mais de um ano.

No Brasil, essa demanda por requalificação pode esbarrar em dificuldades por uma série de fatores sociais e econômicos, visto que 40% dos brasileiros não estão familiarizados com tecnologias de IA e não sabem definir ou explicar as suas funções e aplicações, segundo um estudo realizado pela MOB INC.

De acordo com a pesquisadora Dora Kaufman, muitos trabalhadores que antes já tinham funções pré-determinadas, agora precisam lidar com a inteligência artificial em seu meio: “Motorista de caminhão já dirige há muitos anos, só que os caminhões agora começaram a vir com tecnologia embarcada, inclusive inteligência artificial. E se o motorista não está conseguindo lidar com inteligência com a tecnologia embarcada, ele vai ter dificuldades no seu trabalho também”.

O mesmo se aplica ao agronegócio. Todos os equipamentos e máquinas do agronegócio estão vindo com tecnologia embarcada e aquele que dirigia um trator, por exemplo, super bem, não está conseguindo lidar com a tecnologia embarcada e precisa de formação. É mais complexo essa integração. Antes ele apenas dirigia o caminhão e passava a marcha, sabe? Mas de repente tem toda uma tecnologia embarcada que precisa saber utilizar e interpretar, e isso ele não está conseguindo”.

Dora Kaufman, pesquisadora e professora da USP

Inteligência artificial e psicologia

Por um lado, a IA pode ter um impacto positivo de facilitar tarefas do cotidiano. Além disso, ferramentas de inteligência artificial podem ser usadas em pesquisas para entender melhor os transtornos mentais e desenvolver tratamentos mais eficazes. Um exemplo disso é um estudo da Universidade Johns Hopkins, nos Estados Unidos em que, com o uso de inteligência artificial, foi possível identificar com 91% de precisão quais adolescentes estariam em maior risco de pensamentos e comportamentos suicidas.

No entanto, há também preocupações a respeito do impacto negativo da IA na saúde mental, como por exemplo, o aumento da dependência tecnológica na sociedade, tornando os seres humanos cada vez menos hábeis a executar tarefas simples sem auxílio de tecnologia e limitando parcialmente a nossa criatividade.

O psicólogo especializado em tecnologia Emanuel Querino diz o que ele pensa a respeito do impacto das inteligências artificiais na criatividade e inteligência dos seres humanos:

Acho que não vai atrapalhar a nossa criatividade, porque a gente se adapta muito bem a esses ambientes. Acredito que é só uma realidade diferente. Quando a televisão chegou, as pessoas falavam que ela ia acabar com a criatividade humana, que a gente só ia ficar passiva assistindo uma coisa lá. E não foi bem assim. Então não vejo esse cenário tão catastrófico de que a gente vai perder a criatividade. Eu vejo que a gente vai aprender a usar cada vez mais os sistemas para avançar muito mais a qualidade de vida da espécie humana.“

Emanuel Querino, psicólogo

Um exemplo de aspectos negativos pode estar no aumento considerável de informações e possibilidade de desenvolvimento de vícios, dificultando o controle dos fatores que estimulam, aumentam e perpetuam esses comportamentos viciantes. O psicólogo Emanuel Querino alerta para preocupações com as deepfakes criadas por IA que estão sendo utilizadas para a produção de pornografia, o que pode contribuir com a dependência de pessoas com vícios neste tipo de conteúdo.

Eu acho que a inteligência artificial vai impactar muito na questão de vícios, eu tenho um paciente com dependência de pornografia e ele me contou que agora ele está consumindo pornografia gerada por inteligência artificial”

Emanuel Querino, psicólogo

Em ponderação aos riscos, Emanuel Querino afirma que as tecnologias de IA como o ChatGPT podem funcionar de forma similar ao papel e ajudar a melhorar a memória humana, permitindo que as pessoas terceirizem problemas do cotidiano, como usar uma fórmula do Excel, por exemplo. Isso torna o acesso e uso das informações mais eficiente e lógico, contribuindo para a melhoria da memória dos humanos.

Regulamentação como utopia?

Em 2017, na Califórnia, ocorreu o Beneficial AI, evento que reuniu pesquisadores da IA da academia e da indústria e definiu os 23 Asilomar AI Principles – 23 Princípios Asilomar de Inteligência Artificial. Não são regras, mas foi um conjunto pioneiro de iniciativas com princípios gerais relacionados à ética, privacidade e transparência para as governanças.

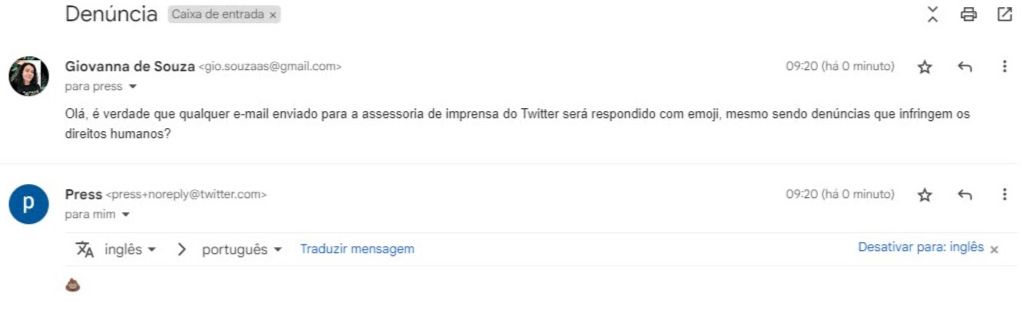

No entanto, o interesse privado pode ter mais força do que tais princípios éticos, uma vez que, até a data da publicação desta reportagem, não há regulamentação e punição por parte do poder público – já que as empresas de plataforma e inteligências artificiais disputam poder de forma assimétrica com os Estados, considerando que as leis a serem seguidas dentro da plataforma muitas vezes disputam com leis seguidas no país em que a plataforma é utilizada. Um exemplo disso é a nova resposta automática pelo Twitter para a imprensa ser um emoji de fezes (💩), com a nova gestão do empresário Elon Musk, independente do tipo de denúncia feita para a plataforma.

No entanto, a regulamentação aparenta estar longe de acontecer: “Até hoje, nós não temos em lugar nenhum do mundo um arcabouço regulatório. Há uma proposta de regulamentação. A proposta mais complexa e mais completa atualmente é a Comissão Europeia. Ela começou a se desenvolver em 2018, em 21 de abril de 2021 ela foi colocada em consulta pública, em novembro do ano passado ela tinha 3 mil emendas. E até agora não se concretizou”, lamenta Kaufman.

LGPD, privacidade e uso de dados

A Lei Geral de Proteção de Dados (LGPD) é uma legislação brasileira que entrou em vigor em setembro de 2020 e que tem como objetivo garantir a proteção da privacidade e dos dados pessoais dos cidadãos brasileiros. Essa lei tem um impacto direto na forma como as empresas lidam com os dados de seus clientes e, consequentemente, na forma como a inteligência artificial será utilizada no futuro.

A partir do momento em que a Lei entrou em vigor no país, as empresas passaram a ter obrigações com relação à transparência e explicabilidade dos algoritmos para seus usuários. O professor da PUC Minas Luiz Felipe Vieira de Siqueira, especializado em Direitos Autorais e Direitos Conexos, explica como as empresas precisam se adequar diante do novo cenário, com a lei em vigor: “As empresas têm que informar como os dados pessoais são tratados, a base legal respectiva, o ciclo de dados (prazo de retenção) e as medidas de segurança que são adotadas”.

Por mais que a coleta, armazenamento, tratamento e compartilhamento desses dados esteja sendo feita de maneira transparente e em conformidade com a LGPD, esse processo é apresentado em termos e condições extensos e que muitas das vezes não são lidos por completo pelo usuário.

Segundo uma pesquisa realizada em 2020 pela instituição financeira britânica Thinkmoney, 90% dos usuários aceitam os termos e condições de aplicativos sem sequer lê-los. Ao que tudo indica, os principais motivos da negligência por parte dos usuários se deve à extensão dos termos, além da complexidade do conteúdo presente no contrato, o que dificulta a compreensão.

O professor Luiz Felipe Vieira nos contou quais são as penalidades e consequências legais que as empresas não cumpridoras da LGPD podem sofrer: “Sanções que podem ir desde uma advertência, passando por multa que vai de 2% do faturamento anual da empresa, limitado a R$50 milhões de reais. Além de bloqueio do banco de dados e eliminação do banco de dados daquela empresa”.

De acordo com dados divulgados em 2021 pelo Instituto de Tecnologia de Massachusetts (MIT), vazamentos de dados aumentaram 493% no Brasil, sendo que mais de 205 milhões de dados de brasileiros foram vazados de forma criminosa em 2019.

Ainda que a LGPD seja um desafio para muitas empresas no Brasil e que ainda há muito trabalho a ser feito para garantir a proteção dos dados pessoais dos cidadãos brasileiros, a legislação tem o potencial de mudar a forma como as empresas coletam e utilizam os dados de seus clientes e, consequentemente, a forma como a inteligência artificial será desenvolvida e utilizada.

Como lembra o professor de Ciência da Computação Flavio Figueiredo, há que se responsabilizar a ação humana presente na etapa de coleta:

“Inteligência artificial é justamente o computador executando tarefas que são ligadas à nossa inteligência. O Chat GPT, por exemplo, é um sistema que foi treinado através de exemplos, que são feitos por meio de perguntas e respostas. Esses exemplos vão alimentar a rede neural, assim formando esse sistema que lida bem com tarefas de texto. A tarefa humana que alimenta essa rede.”

Flavio Figueiredo

Interesse vs. Acesso

De acordo com um levantamento de dados do Google Trends realizado ao final de abril de 2023, o Chat GPT, interface de diálogo que teve o lançamento em 30 de novembro de 2022, teve seu pico de buscas em 13 de abril de 2023, o que indica uma linha ascendente pelo interesse.

De maneira similar, outro levantamento pelo Google Trends implica que os acessos no Brasil são em estados do Sul e Sudeste, além do Distrito Federal em primeiro lugar. Pode-se dizer, assim, que regiões com maior acesso à internet (Pnad, Pesquisa Nacional por Amostra de Domicílios, 2013) se interessaram mais pelo assunto, o que infere no acesso da população sobre o tema das inteligências artificiais e os usos no cotidiano.

Reportagem produzida por Danilo Valadares, Giovanna de Souza, Guilherme Geoffroy, Izabelly Rigueira, Lara Aguiar e Pedro Januzzi, na disciplina de Laboratório de Jornalismo Digital, no semestre 2023/1, sob a supervisão da Professora Verônica Soares da Costa.

Parabéns. Ótimo trabalho. Muito inteligente a maneira que foi apresentado a existência atual da IA em nosso meio,(Ganhos, perdas, preocupações, etc) demostrando que o conhecimento humano não tem barreiras.

Sensacional a reportagem! Chega a dar medo…não sei se há limite.

[…] https://blogfca.pucminas.br/colab/inteligencia-artificial-futuro/ […]

[…] https://blogfca.pucminas.br/colab/inteligencia-artificial-futuro/ […]

[…] À medida que a IA se desenvolve, questões éticas ganham relevância, exigindo abordagens que equilibrem inovação e princípios morais, como enfatizado pela PUC Minas. […]

[…] À medida que a IA se desenvolve, questões éticas ganham relevância, exigindo abordagens que equilibrem inovação e princípios morais, como enfatizado pela PUC Minas. […]

[…] Como a inteligência artificial vai afetar o seu futuro? – Colab […]